Suponha que você tenha observado um fenômeno e deseja saber se ele é recorrente ou fruto do acaso. Para isso, devemos possuir um número de amostras de uma população (conjunto de todos os elementos) e tentarmos verificar o quanto podemos considerar esse evento algo estatisticamente recorrente ou raro. Porém, e se as amostras coletadas representarem somente um pequeno grupo? Quais critérios ou parâmetros (medidas numéricas que descrevem uma população) podem ser utilizados para classificar e julgar os grupos?

Definições

Uma hipótese é uma formulação ou suposição provisória e admissível, com intenções de ser posteriormente demonstrada ou verificada. A hipótese surge no pensamento científico após o recolhimento de dados observados e da necessidade de explicação destes e dos fenômenos a estes associados. É normalmente seguida de experimentação, que pode levar à verificação ou refutação da hipótese. Assim que verificada, a hipótese passa a se chamar postulado, podendo alcançar o status de lei. Uma lei é usada para descrever uma ação sob certas circunstâncias. Se for possível obter um tipo de lema do qual as leis empíricas possam ser deduzidas, o mesmo é denominado como princípio.

Uma teoria científica consiste de uma ou mais hipóteses que foram apoiadas com testes repetidos. As teorias são um dos pilares da ciência e amplamente aceitas na comunidade científica como sendo verdade. Para permanecer uma teoria, não deve nunca ser errada; se for, a teoria é refutada ou também pode evoluir, acrescentando novas partes. Isso é bem diferente do jargão popular, que considera algo como “apenas uma teoria” como sendo uma resposta imaginária à explicação de um problema e que aceitaria outras suposições para explicar o fenômeno.

Na matemática, axioma é uma proposição que se aceita sem comprovação para poder fundamentar uma teoria, das quais se deduzem outras conclusões por raciocínio lógico. Postulado é uma sentença que não é provada ou demonstrada, e por isso se torna óbvia ou se torna um consenso inicial para a aceitação de uma determinada teoria. A diferença entre axioma e postulado é que o axioma contém evidência em si próprio e por isso não precisa ser demonstrado. Hipóteses são as proposições de que se parte para demonstrar outras. As proposições demonstradas são ditas Teoremas.

Teste de hipótese

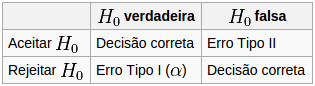

Esse é o processo que usa estatísticas amostrais e uma metodologia para testar uma afirmação sobre um parâmetro de uma população através da probabilidade de cometer determinados tipos de erro nesse julgamento. Esse erro pode acontecer se rejeitar uma hipótese verdadeira (erro tipo I) ou aceitar uma hipótese falsa (erro tipo II).

De início, existem duas hipóteses que devem ser consideradas. A Hipótese Nula (H0) afirma que não possui diferença significativa de parâmetros entre nossa amostra e a população de referência, portanto os valores sao explicados por erros amostrais ou estão dentro da incerteza de medição. Já a Hipótese Alternativa (HA) diz que há diferença, ou seja, a amostra não pertence à população de referência e constitui um novo grupo (nova evidência) – é aquilo que queremos provar com um alto nível de confiança.

Para provar uma ou outra hipótese, deve-se estabelecer um critério de raridade (nível de significância α ou p-valor). Também é estabelecido um intervalo de valores (região crítica) que, se acontecerem em nossa amostra, significa que é um evento raro e rejeitamos a hipótese nula. Esse intervalo deve considerar o tamanho da amostra e o nível de confiança desejado; sua área é igual ao nível de significância, e sua direção é a mesma da hipótese alternativa.

A probabilidade de incidirmos em um erro tipo I (rejeitar uma hipótese verdadeira) é chamada de nível de significância do teste (α) – quanto menor for o valor de α, o resultado da amostra é mais significante para rejeitar H0. Esse valor pode ser definido arbitrariamente pelo pesquisador ou através da probabilidade de significância (veja mais abaixo), mas normalmente é igual a 5% em um evento raro e 1% (ou mesmo 0,1%) em um evento raríssimo. Já a probabilidade de se incorrer no erro tipo II (aceitar hipótese falsa) é denominada β, sendo mais difícil defini-la porque normalmente a Hipótese Alternativa de um problema não contém muitos elementos. Ao se diminuir a probabilidade de Erro I, aumenta-se a chance de Erro II.

Para escolher qual erro aceitamos cometer, devemos considerar qual seria mais prejudicial e quais seriam os possíveis impactos. Por exemplo, na dúvida entre existir ou não influência humana no aquecimento global, devemos ignorar medidas anti-poluição atmosférica em favor do desenvolvimento econômico?

Roteiro para o teste de hipótese:

- Definir as hipóteses nula e alternativa;

- Especificar as evidências estatísticas (distribuição e estimadores, como média e desvio padrão) que serão utilizadas para testar a hipótese nula;

- Fixar um valor para o nível de significância; com α escolhido, os parâmetros que desejamos testar e os que obtemos do problema, construímos a região crítica, que nos servirá de regra de decisão para rejeitarmos ou não a hipótese nula;

- Retiramos da população uma amostra para executarmos os cálculos definidos e determinarmos o valor da estatística de teste;

- Se o valor da estatística, calculado com os dados da amostra retirada da população, pertencer à região crítica estabelecida pelo nível de significância, deve-se rejeitar a hipótese nula. Se não pertencer, não rejeitar a hipótese nula – nesse caso, o procedimento pode ser repetido com diferentes valores para o nível de significância.

Uma outra maneira de tomar-se uma decisão é comparar o valor tabelado com a estatística do teste. Supondo que o resultado do experimento tenha sido fruto do acaso, qual seria a probabilidade de observarmos um resultado tão extremo ou mais extremo do que de fato foi observado? A probabilidade de significância (ou p-valor) do teste permite determinar melhor um valor para o nível de significância α. O p-valor (ou valor P ou ‘p-value’) é a probabilidade de que a estatística do teste tenha valor extremo em relação ao valor observado quando a hipótese H0 é verdadeira, ou seja, é o menor nível de significância com que não se rejeitaria a hipótese nula. Uma explicação bem direta com exemplo é dada no post do Dummies sobre como testar se uma amostra tem distribuição normal no R.

A associação americana de estatística fez um comunicado sobre o que é o ‘p-value’: podem indicar quão incompatíveis os dados estão com um modelo estatístico específico; não medem a probabilidade de que a hipótese estudada é verdadeira, ou a probabilidade de que os dados foram produzidos por acaso sozinho, ou o tamanho de um efeito ou a importância de um resultado; por si só, um ‘p-value’ não fornece uma boa medida de evidência a respeito de um modelo ou hipótese.

Em vez de se calcular a região crítica para aceitar ou rejeitar a hipótese, calcula-se qual a probabilidade de ocorrerem valores para o valor médio ou p mais desfavoráveis à hipótese nula. Rejeitamos H0 se o p-valor é menor que α e não rejeitamos H0 caso contrário. Em muitos casos, em vez de se determinar simplesmente se H0 é rejeitada, diz-se que H0 é rejeitada a um determinado nível de p-valor. Por exemplo, pode-se rejeitar a hipótese nula a 5% caso o p-valor seja menor que 5% (0.05). A seguir julga-se se tal valor consiste em um evento raro – um p-valor pequeno significa que a probabilidade de obter um valor da estatística de teste como o observado é muito improvável, levando assim à rejeição da hipótese nula. Amostras grandes tendem a produzir valores-p pequenos, ainda que o efeito observado não tenha grande importância prática.

O problema dos parafusos

Uma empresa deve decidir da compra de um lote contendo parafusos de duas empresas com diferentes valores de resistência a tração: os da fábrica A tem resistência a 145 kg com desvio padrão de 12 kg, enquanto os da fábrica B tem média de 155 kg com desvio padrão de 20 kg. Note que a fábrica B tem uma resistência média maior, mas um desvio padrão maior, ou seja, tem uma possibilidade maior de atingir menores valores de resistência do que os parafusos do concorrente. Qual fabricante seria melhor?

Escolhendo uma amostra aleatória de 25 parafusos de um lote contendo os dois tipos de parafusos, obtém-se que a resistência média dese grupo é de 148 kg. Comparando-se os três valores médios, os parafusos pertençam à fábrica A de acordo com esse critério (148 está mais perto de 145 do que 155). No entanto, esses elementos podem pertencer a um grupo de parafusos da fábrica B, já que esse valor 148 está dentro de um desvio padrão ao redor da média de B.

Seguindo o roteiro do teste de hipótese, temos:

- Erro de tipo I: concluirmos que os parafusos são de A, quando na verdade são de B (ou seja, a amostra, oriunda de B, apresenta média inferior que 150kg).

- Erro do tipo II: concluirmos que os parafusos são de B, quando na realidade são de A (ou seja, a amostra, oriunda de A, apresenta média superior a 150kg).

- H0: os parafusos são do país B (média de 155kg e desvio padrão de 20kg).

- HA: os parafusos são do país A (média 145kg e desvio padrão 12kg).

Definindo o teste normal (Z, que é a distância da média em relação ao desvio padrão da média) e considerando a média da amostra (148 kg), podemos utilizar o teorema do limite central para estipular uma média (a mesma da população) e um desvio padrão para a amostra em cada hipótese. Então, podemos calcular a probabilidade de erro tipo I e II, utilizando como região crítica (RC) os valores menores ou iguais a 150kg – ou seja, para erro tipo I (H0 verdadeira), x pertence ao raio crítico e para erro tipo II (HA verdadeira), x não pertence ao raio crítico. Assim, utilizando a definição de Z, é possível calcular o nível de significância α e β:

\(s=\frac{\sigma}{\sqrt n}=\frac{20}{\sqrt{25}}=4\)

\(P(erro I)=P(Z\le\frac{150-155}{4})=P(Z\le-1,25)=10,56\%=\alpha\)

\(s=\frac{\sigma}{\sqrt n}=\frac{12}{\sqrt{25}}=2,4\)

\(P(erro II)=P(Z\gt\frac{150-145}{2,4})=P(Z\gt-2,08)=1,88\%=\beta\)

Os valores de P(Z) foram obtidos através de uma tabela de distribuição normal padrão (clique no link para ver o procedimento), que contém os valores de área sob a curva normal padronizada (média zero e desvio padrão igual a um).

Os níveis α e β obtidos dizem que estaremos cometendo o erro de tipo I com maior probabilidade do que o erro do tipo II, ou seja, a regra de decisão privilegia a afirmação de que os parafusos são de A.

Testes de Independência, Homogeneidade e Aderência

Comparar dados de populações visa determinar a aderência de um conjunto de dados à uma distribuição específica, homogeneidade dessa distribuição e independência (ou associação) entre duas variáveis aleatórias. Os testes não-paramétricos servem para medir a distância entre os valores observados e aqueles que seriam esperados se eles possuíssem determinada distribuição. Diferentemente dos testes paramétricos, esses não se baseiam diretamente em parâmetros da distribuição, necessitando assim de menos pressupostos (não exige-se uma distribuição probabilística conhecida da estatística de testes nem uma distribuição normal dos erros).

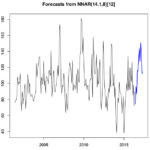

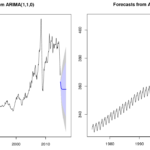

Em linguagem R, calculando-se o modelo ARIMA “model” aplicado à série temporal “dados.ts” (gerada a partir da tabela “dados” lida de um arquivo), pode-se definir as grandezas estatísticas explicadas acima através dos seguintes comandos:

# Coeficente de Correlação de Pearson para todas as combinações de variáveis cor(dados) # R^2 do ajuste linear summary(model)$r.squared # R^2 dos valores ajustados ao modelo de regressão não-linear cor(fitted(model),dados.ts)^2 # Qui-quadrado, graus de liberdade e p-valor chisq.test(dados)

• Teste de independência

Calculado sobre uma amostra a partir de uma única população (cada indivíduo da população é classificado em duas formas). É usado para descobrir se existe uma associação entre a variável de linha e coluna variável em uma tabela de contingência. Essa tabela é construída à partir de registros de observações independentes de duas ou mais variáveis aleatórias, como em uma tabela onde as colunas são “fumante” e “não fumante” e as linhas são “desenvolveu câncer” e “não desenvolveu câncer”, constando os totais das linhas e das colunas. A hipótese nula é de que as variáveis não estão associadas, ou seja, a distribuição conjunta é o produto das distribuições marginais, o que só ocorre quando existe independência entre as variáveis aleatórias. A hipótese alternativa é de que as variáveis estão associadas, ou dependentes.

## teste de independência

# Dados observados (numero de copos de alcool ingeridos por semana x desenvolvimento ou não de doença)

Oi = matrix(c(146,106,29,750,590,292), byrow=TRUE, 2, 3, dimnames=list(c("sim","não"), c(0,"<7",">7")))

print(Oi)

# Valores esperados (produto de linhas por colunas dividido pela soma)

Ei = outer(rowSums(Oi), colSums(Oi), "*")/sum(Oi)

# Qui-quadrado

X2 = sum((Oi-Ei)^2/Ei)

# Graus de liberdade

nu = prod(dim(Ei)-1)

# P-valor

pvalue = pchisq(X2, df=nu, lower.tail=FALSE)

# As três linhas acima podem ser calculadas usando somente a função chisq.test()

chisq.test(Oi)

• Teste de homogeneidade

Pode ser usado para comparar as proporções em diferentes populações. Ele testa a hipótese nula de duas ou mais amostras serem provenientes de uma mesma distribuição de probabilidades. Os valores esperados são obtidos pelo produto da linha marginal e tamanho das amostras.

## teste de homogeneidade

# Leitura de tabela (interessa aspecto x profundidade)

ag = read.table("http://www.leg.ufpr.br/~walmes/cursoR/agreg.txt", header=TRUE, sep="\t")

str(ag)

# Montar histograma

ht = hist(ag$aspecto)

# Classes de aspecto

classes = ht$breaks

# Atribuição às classes

cla = cut(ag$aspecto, classes)

# Dados observados

Oi = table(ag$profundidade, cla)

# Valores esperados (produto de linhas por colunas dividido pela soma)

Ei = outer(rowSums(Oi), colSums(Oi), "*")/sum(Oi)

# Qui-quadrado, Graus de liberdade e P-valor

chisq.test(Oi)

• Teste de aderência

Testa a hipótese da amostra ser proveniente de uma distribuição de probabilidade definida em H0, daí sendo obtidas as frequências esperadas (E). As funções utilizadas são as mesmas do teste de independência, somente variando a interpretação. Caso precise estimar alguma variável, isso diminui um grau de liberdade, o que não é considerado ao usar a função “chisq.test()”.

Veja o seguinte exemplo de teste de aderência: um dado é lançado 1200 vezes e você deve testar a hipótese de que o dado é honesto ao nível de 5%. Os valores de frequência para cada número que caiu no dado são:

| Ocorrência | Frequência |

|---|---|

| 1 | 190 |

| 2 | 179 |

| 3 | 228 |

| 4 | 183 |

| 5 | 226 |

| 6 | 194 |

- Erro de tipo I: considerar que o dado não é viciado (ou seja, conjunto apresenta média igual a 200 ao nível de 5% de significância)

- Erro de tipo II: considerar que o dado é viciado (ou seja, conjunto apresenta média é diferente de 200 ao nível de 5% de significância)

- H0 – o dado não é viciado (média igual a 200)

- HA – o dado é viciado (média diferente de 200)

Considerando que trata-se de uma distribuição normal, temos média de 200 e desvio padrão de 21,57. Caso fosse uma tabela de contingência, os valores esperados para cada célula deveriam ser calculados por uma regra de três considerando os totais (veja nesse outro exemplo de teste de qui-quadrado). A frequência para cada ocorrência deveria ser de 1200/6 = 200, sendo esse o valor esperado para todas as ocorrências. Calculando o valor de qui-quadrado, temos χ² = 11,63.

Temos 6 ocorrências, resultando em n -1 = 5 graus de liberdade. Com α também definido, consultar a probabilidade correspondente na tabela do qui-quadrado, que é 11,07. Assim, definimos a região crítica como RC ≥ 11,07. Por quê sempre é maior ou igual (ou seja, para direita no gráfico)? Quanto mais perto de zero, menor a diferença entre o esperado e o obtido e as variáveis são independentes.

Como o valor da nossa estatística de teste é maior ou igual ao valor da região crítica, é um evento raro e rejeita-se H0. Ao rejeitar a hipótese nula (H0), existe uma forte evidência de sua falsidade, ou seja, de que o dado está viciado, e assim temos que é mais provável que o dado esteja viciado. Caso aceitássemos a hipótese nula, diríamos que não houve evidência amostral significativa no sentido de permitir a rejeição de Ho – o valor de qui-quadrado pertenceria à região crítica.

Também temos o p-valor (1 – β) para 5 graus de liberdade observando na tabela do qui-quadrado a probabilidade maior que o valor de χ² calculado (11,63), que é 11,644 e corresponde a uma probabilidade de 4%. Esse é o menor nível de significância com que não se rejeitaria a hipótese nula. Assim, pode-se rejeitar a hipótese nula a 5%, pois o p-valor é menor que essa porcentagem. Em outras palavras, hipótese de que os dados não estejam viciados é significante ao nível de 5%.

Outro ponto importante nos testes é a análise de resíduos, que pode ser vista no post sobre Modelo ARIMA. Existem outras análises que podem ser usadas. Para saber se há diferenças estatisticamente significativas entre os desvios-padrão de duas amostras (ou seja, se elas são ou não homocedásticas), usamos o teste de variância.

Pode-se testar uma variância nos mesmos moldes de teste de médias, utilizando-se a distribuição qui-quadrado ou a distribuição F (Fisher-Snedecor), definido pela razão entre as variâncias das duas amostras comparadas. A ANOVA (ANalisys Of Variance, ou análise de variância) permite fazer a comparação global de diversas amostras ou subamostras, minimizando a probabilidade de erro amostral, já que, conforme aumenta o número de amostras, o total de comparações entre pares aumenta exponencialmente.

Fontes

- Métodos quantitativos para ciências sociais – Slides das aulas do Prof. Marcos Vinicius Pó (UFABC)

- Estatística Básica (2004) – Bussab & Morettin

- Teste de hipótese – Prof. Sergio Kato (PUCRS)

- Cálculo e interpretação do p-valor – Portal Action

- Teste Qui-quadrado para homogeneidade – Portal Action

- Os testes chi-quadrado – Ridículas: dicas curtas sobre R

- Como Calcular o Valor P – wikiHow

- Análise Real

5 comments